Hugging face是一个专注于NLP的公司,拥有一个开源的预训练模型库 Transformers ,里面囊括了非常多的模型例如 BERT GPT 等

模型库

https://huggingface.co/models

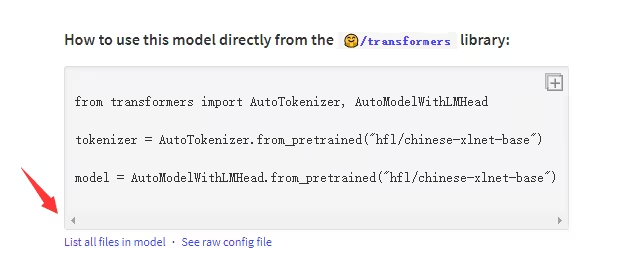

使用模型

from transformers import *

model_name = 'hfl/chinese-xlnet-base'

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModel.from_pretrained(model_name)

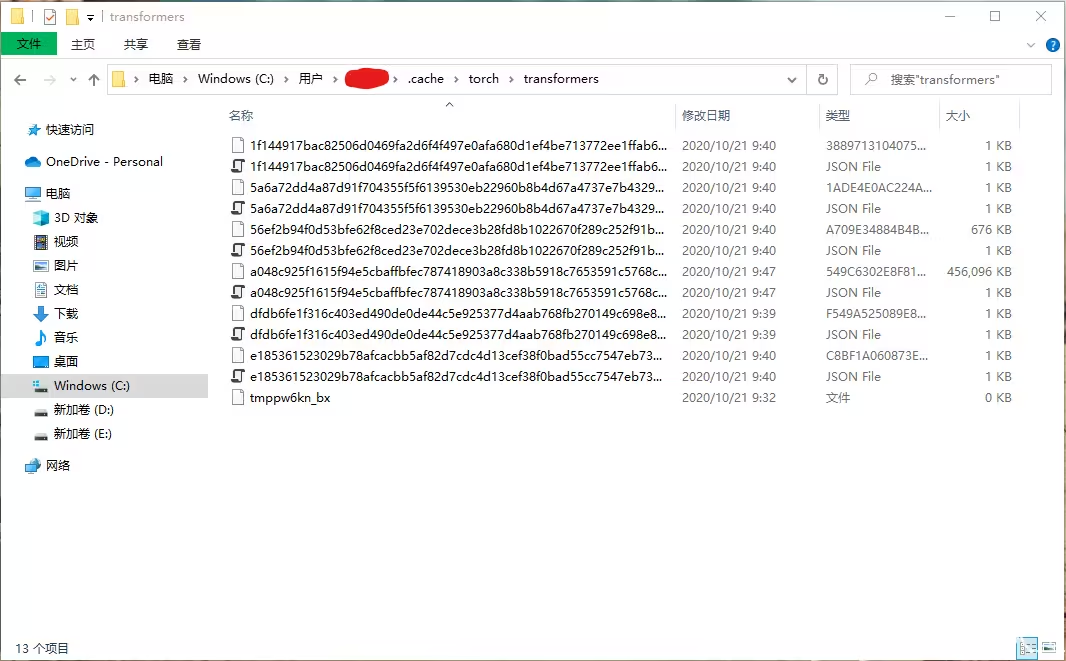

使用Windows模型保存的路径在 C:\Users\[用户名]\.cache\torch\transformers\ 目录下,根据模型的不同下载的东西也不相同

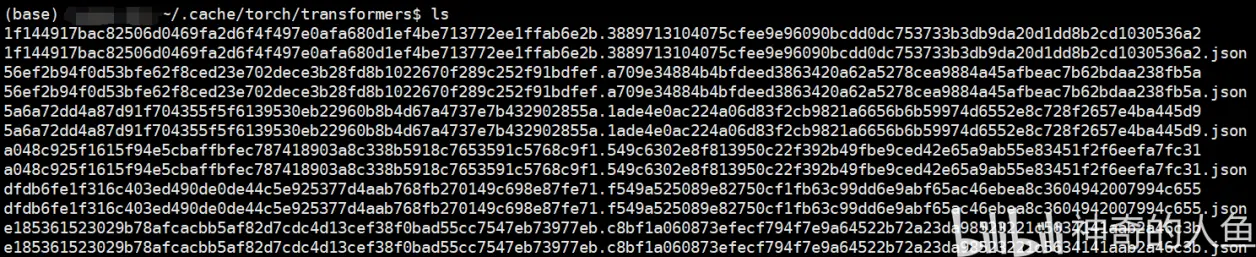

使用Linux模型保存的路径在 ~/.cache/torch/transformers/ 目录下

存在的问题

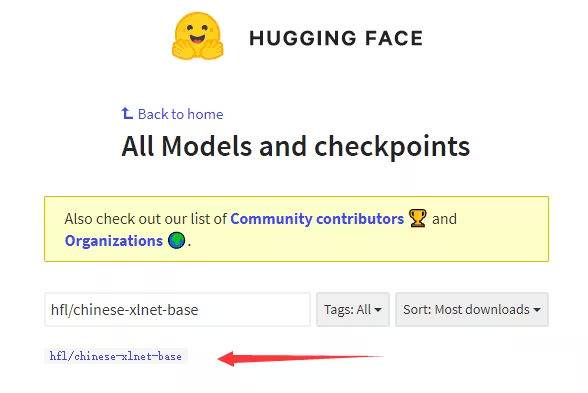

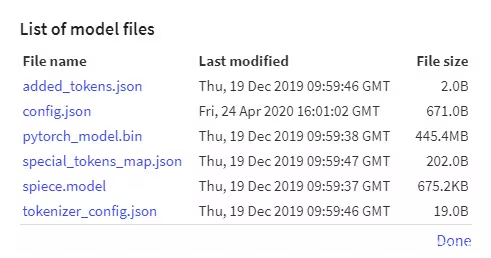

这时候就需要把模型文件下载后在导入代码中,还是以刚才的 hfl/chinese-xlnet-base 模型为例,直接在官网搜索模型,点击进入模型的详情界面

在界面中找到 List all files in model

把弹窗内的文件全部下载下来

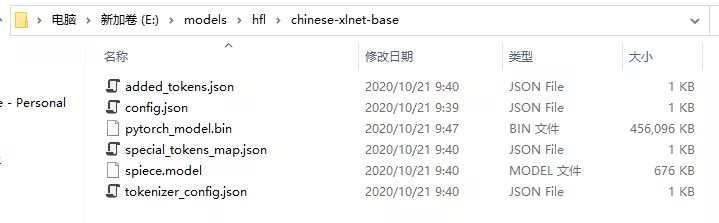

我们假设文件保存在 E:\models\hfl\chinese-xlnet-base\ 目录下

我们只需要把 model_name 修改为下载的文件夹即可

from transformers import *

model_name = 'E:/models/hfl/chinese-xlnet-base/'

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModel.from_pretrained(model_name)

这样问题就解决了,linux同理这里就不再赘述