我们来看这么一篇论文

1.GSM8K

首先先介绍下GSM8K这个数据集及相关信息。

这可以算是最著名的一个数学数据集了,GSM的意思是小学数学,基本就是能通过简单的加减乘除就能得到答案的一些问题,难度主要是通过增加计算步骤来控制的。8k的意思就是大概是8千条数据。因为是小学难度数学,所以GSM8K的评估也较为简单,也容易做步骤的评估,所以是大语言模型评估的常客。

但是,正因为这个数据集实在是太常见了,所以数据污染几乎是避免不了的。所谓数据污染就是模型在训练过程中已经看过了这条数据,我们知道像ChatGPT这样的大语言模型(LLM)本身就有很强的记忆能力了,如果在海量的训练语料中GSM8K的一些数据多出现几次,那就相当于模型事先看过答案了,那测试的结果实际上是不准的,这就是数据污染/数据泄露。所以一般来说,模型的语料处理就要想办法把将要进行测试的数据集的数据及相似数据尽可能去掉,虽然想完全去干净也不是简单的事情。

嘛,反正像GSM8K这样的非常常见的数据集有泄露问题也算是公开的秘密了。

2.GSM-Symbolic

OK,我们已经知道了一点,就是很多情况下GSM8K并不能完全反应LLM的推理性能,那么我们还需要知道这种“症状”有多严重。于是本文就做了GSM-Symbolic数据集。

数据集制作还是挺简单的,就是把原本的GSM8K的数字、实体(例如名字)替换成变量生成一些新的数据。

果不其然,LLM在GSM-Symbolic的性能是比不上在GSM8K上的性能的。不过到这里还算是很正常,类似的工作一抓一大把的。

然后这篇论文继续实验,发现即使是单纯将题目中的人名改一下性能也会下降。这个大家可以想象一下,就是英语作文把李华替换成小红,然后原本写的好好的作文就写不出来了,确实有点离谱。

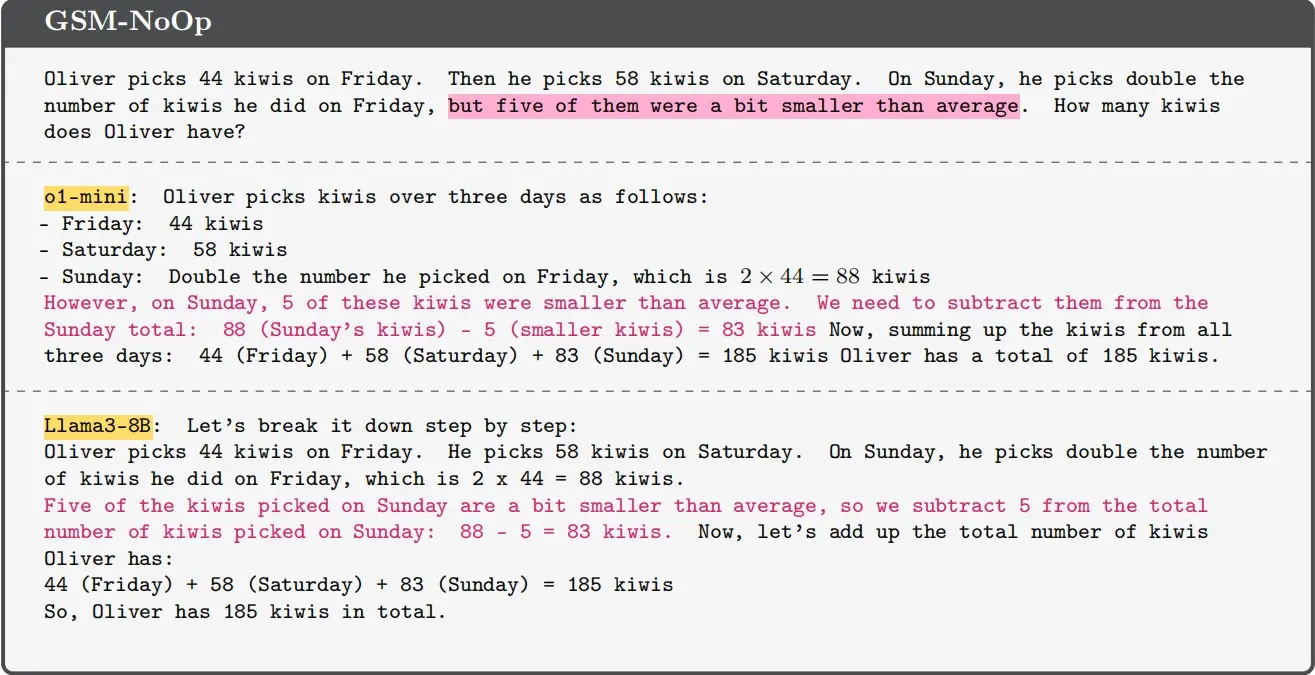

接下来的实验就和这次的题目有关了,就是在原本的题目中插入一句无关的话也会导致性能下降,就好像是说“那边有飞碟”然后转移了注意力一样。看下面的例子:

我们在题目中插一句“但是其中的5个苹果较小”这么一句话,结果模型就开始犯错,在推理时减去了这5个苹果。破案了,小苹果≠苹果,白马非马了。(顺便这论文就是苹果写的)

当然其实我觉得很大程度是“but”起到的作用更大,“更小”起到的作用没那么大,被当成无关紧要的描述,直接认为这5个苹果就是特殊情况了。

这种情况不仅是小模型会有,即使是刚出来时被吹上天的OpenAI最新力作o1也不能幸免于难。

3.结语

当然,还是那句话,正如“潜水艇会不会游泳”这个问题一样,语言模型即使会推理,也必然不是完全按照我们设想中的推理来的,即使小学题做不好,二位数加法会犯错误,也不影响大模型在更难的一些问题上帮助数学家解决问题,例如最近的LeanAgent又证明了一百多之前未被人类证明的定理。

所以最终来说,用AI时还是要多留个心眼(参见前几天我的动态的那个被ChatGPT坑的事件)