这里是LLM SPACE,每日分享最新最全的AI资讯与研究。希望通过传播内容吸引更多对AI感兴趣的朋友,共建华人AI生态!

如果你有大模型相关的创业想法,或者对AI有一些有趣的想法,欢迎来找我们聊聊!

01

OpenAI COO 最新彭博对话:Sora 仍处商业化早期,AI 技术如果能在行业中产生通缩,会有更多东西被创造出来

这是 OpenAI COO Brad Lightcap 在旧金山 Bloomberg Tech 上展开的最新对话,Lightcap 谈到了 OpenAI 在 AI 方面的商业应用。Lightcap 重点阐释了 AI 技术如何为企业带来差异化价值,并提升客户体验和创新能力。此外,Lightcap 也谈及了与微软的紧密合作关系,包括 Sora的最新进展。

02

多模态AI是医学的未来,谷歌推出三个新模型,Med-Gemini迎来大升级

许多临床任务需要了解专业数据,例如医学图像、基因组学,这类专业知识信息在通用多模态大模型的训练中通常不存在。在上一篇论文的描述中,Med-Gemini 在各种医学成像任务上超越 GPT-4 系列模型实现了 SOTA!在这里,Google DeepMind撰写了第二篇关于 Med-Gemini 的论文。在 Gemini 的多模态模型的基础上,该团队为 Med-Gemini 系列开发了多个模型。这些模型继承了 Gemini 的核心功能,并通过 2D 和 3D 放射学、组织病理学、眼科、皮肤病学和基因组数据的微调,针对医疗用途进行了优化:1、Med-Gemini-2D:能够处理放射学、病理学、皮肤科、眼科图像;2、Med-Gemini-3D:能够处理 CT 图像;3、Med-Gemini-Polygenic:能够处理基因组「图像」。

03

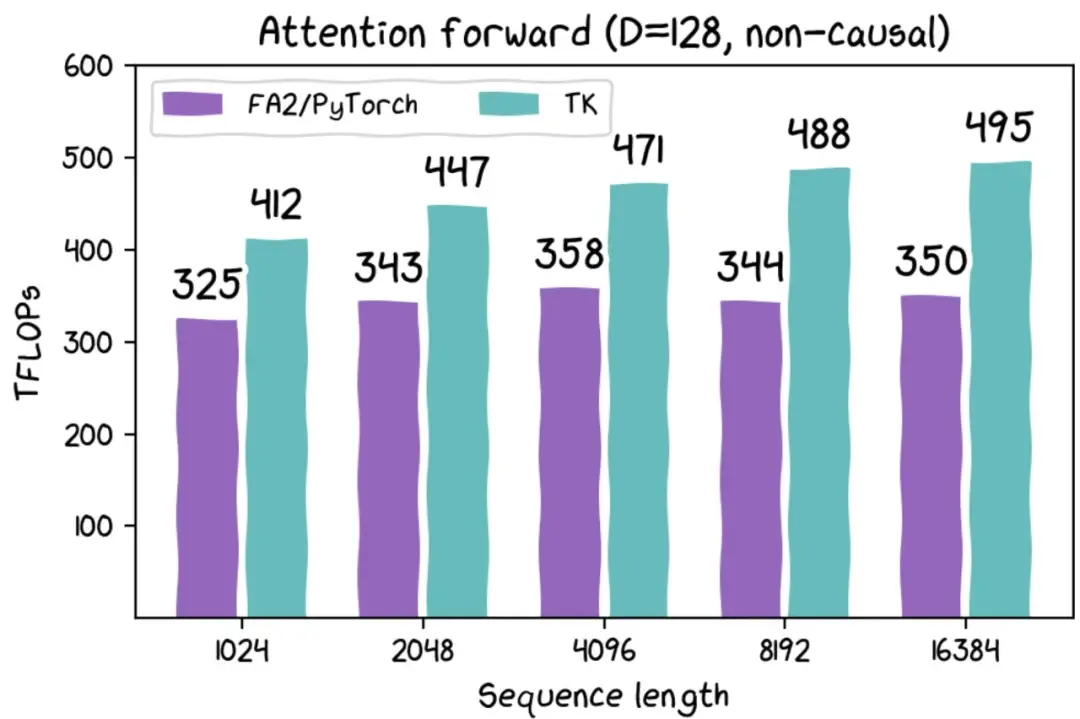

只需百行代码,让H100提速30%,斯坦福开源全新AI加速框架

AI 的快速发展,伴随而来的是大计算量。这就自然而然的引出了一个问题:如何减少 AI 对计算的需求,并提高现有 AI 计算效率。为了回答这一问题,来自斯坦福的研究者在博客《GPUs Go Brrr》中给出了答案。文章主要专注于两个问题:一是硬件真正需要什么?二是如何满足硬件需求?文章用大量篇幅讨论了如何让 GPU 更快的运行,并发布了一个库 ThunderKittens,用户可以很容易地在 CUDA 上编写快速的深度学习内核。其具有以下特点:

- 简单,ThunderKittens 写起来非常简单。

- 可扩展性,如果用户需要 ThunderKittens 无法提供的功能,可以进行功能扩展。

- 速度快。

04

新的Siri将来自OpenAI:苹果和OpenAI敲定协议

苹果公司正在与OpenAI敲定协议,将ChatGPT置于iPhone上,同时与谷歌就使用Gemini进行谈判

去年,苹果首席执行官蒂姆·库克表示他个人使用OpenAI的ChatGPT,但他补充说还有“一些问题需要解决。”

据熟悉此事的人士透露,苹果公司已接近与初创公司OpenAI达成协议,将其技术用于iPhone,这是将人工智能功能引入其设备的更广泛推动的一部分。

Bindu Reddy:显然,苹果与OpenAI的交易刚刚完成!就在语音助手宣布的前一天 :)

看来苹果决定它自己无法完成这件事 🤷

新的Siri将来自OpenAI

05

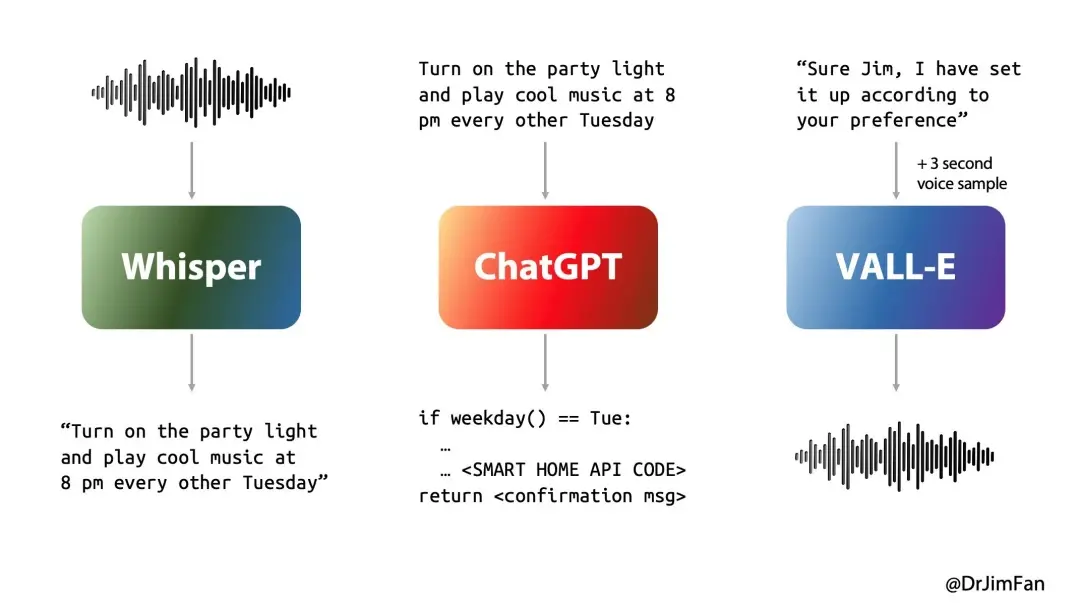

Jim Fan谈OpenAI即将推出的语音助手:或许可以只用一个神经网络将音频映射到音频

OpenAI 预计明天将展示一个实时语音助手。提供一种沉浸式甚至神奇的体验需要什么?

几乎所有的语音AI都经历3个阶段:

- 语音识别或“ASR”:音频 -> 文本1,想想Whisper;

- 计划下一步说什么的LLM(大型语言模型):文本1 -> 文本2;

- 语音合成或“TTS”:文本2 -> 音频,想想ElevenLabs或VALL-E。

去年,我制作了下面的图表来展示如何使Siri/Alexa提升10倍。然而,简单地经历这3个阶段会导致巨大的延迟。如果我们每次回复都要等待5秒,用户体验会急剧下降。这破坏了沉浸感,即使合成的音频本身听起来很真实,也会感觉无生气。

自然对话根本不是这样工作的。我们人类:

这不仅仅是让这3个神经网络依次变得更快那么简单。解决实时对话需要我们重新思考整个技术栈,尽可能地重叠每个组件,并学习如何实时进行干预。

或许更好的方法是 - 只用一个神经网络将音频映射到音频。端到端总是胜出。

我将勾画出如何设计这样一个模型及其训练管道。同时,让我们拭目以待,看看OpenAI能推进到何种程度!

外界噪声多,看这日报,足矣!

欢迎在下方反馈您宝贵的阅读意见!

欢迎您积极转发,让更多人看到LLM SPACE!